"好友"突然来视频,10分钟骗430万!

近期“AI换脸”新型诈骗频发

利用人工智能(AI)

实施电信诈骗的典型案例冲上热搜

引发全网关注

“好友”突然打来视频

10分钟被骗走430万元

近日,“平安包头”公众号发布一起利用人工智能(AI)实施电信诈骗的典型案例,福州市某科技公司法人代表郭先生10分钟内被骗430万元。

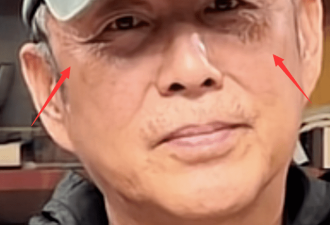

4月20日11时40分左右,福州市某科技公司法人代表郭先生的好友突然通过微信视频联系到他,两人经过短暂聊天后,好友告诉郭先生,自己的朋友在外地投标,需要430万元保证金,且需要公对公账户过账,所以想要借用郭先生公司的账户走一下账。

好友向郭先生要了银行卡号,声称已经把钱打到郭先生的账户上,还把银行转账底单的截图通过微信发给了郭先生。基于视频聊天信任的前提下,郭先生没有核实钱是否到账,于11时49分先后分两笔把430万元给对方打了过去。

钱款转账后,郭先生给好友微信发了一条消息,称事情已经办妥。但让他没想到的是,好友回过来的消息竟然是一个问号。

郭先生拨打好友电话,对方说没有这回事,他这才意识到竟然遇上了“高端”骗局,对方通过智能AI换脸技术,佯装成好友对他实施了诈骗。

“从头到尾都没有和我提借钱的事情,就说会先把钱给我打过来,再让我给他朋友账户转过去,而且当时是给我打了视频的,我在视频中也确认了面孔和声音,所以才放松了戒备”,郭先生说。

幸运的是,接到报警后,福州、包头两地警银迅速启动止付机制,成功止付拦截336.84万元,但仍有93.16万元被转移。

对于AI换脸诈骗,有网友认为太可怕,也有人认为,以后借钱得当面谈了。

AI诈骗常用手法

据湖北网警巡查执法5月6日消息

AI技术的新骗局来袭后

诈骗成功率竟接近100%

AI技术

如何介入新骗局?

有什么新的诈骗方式?

注意了

第一种是声音合成

骗子通过骚扰电话录音等来提取某人声音,获取素材后进行声音合成,从而可以用伪造的声音骗过对方。

第二种是AI换脸

因为人脸效果更易取得对方信任,骗子用AI技术换脸,可以伪装成任何人,再通过视频方式进行信息确认。

第三种是转发微信语音

除了AI换脸、合成语音外,还有一些诈骗手段也可谓防不胜防,就在前不久就有骗子通过转发微信语音的方式行骗。

在盗取微信号后,骗子便向其好友“借钱”,为取得对方的信任,他们会转发之前的语音,进而骗取钱款。尽管微信没有语音转发功能,但他们通过提取语音文件或安装非官方版本(插件),可实现语音转发。

第四种是AI筛选受骗人群

值得一提的是,这些骗局中,骗子不是漫无目的地全面撒网,而是根据所要实施的骗术,通过AI技术筛选受骗人群,别有用心地锁定特定对象。例如,当进行金融诈骗时,经常搜集投资信息的小伙伴就会成为他们潜在的目标。

“迪丽热巴”“杨幂”等明星直播卖货?

AI换脸或涉嫌侵权

除了诈骗钱财,此前还有女子被人利用AI“一键脱衣”造黄谣,某男子利用视频合成技术,将电视剧中与某知名女星亲吻的男主角换成自己以蹭流量,效果都到了以假乱真的地步。在直播间,AI实时换脸也带来了侵权危害。

“点进直播间一看,‘迪丽热巴’居然在直播卖货。”近日,有网友点开直播间,却发现正在卖货的竟是“当红女星”。然而再定睛一看,这些带货“明星”很快露出了马脚——身穿中式服装,正在卖力带货的“明星”们,其实只是使用了AI实时换脸技术的普通主播。

有视频换脸研究者表示,实时换脸不存在延迟,也不会有Bug,而直播画面传输的延迟则取决于使用者的网络配置和进行直播的平台。

作为一种基于深度学习算法的

信息技术

人工智能本身是中性的

但背后操作、设定、使用的是真实的人

AI可以为生活带来便利

也可被用来牟利作恶

这也提醒我们

普及人工智能技术时

必须以法律和道德加以规范

对于AI换脸新骗局你怎么看?

网友评论