月球有猫?奥巴马是穆斯林?谷歌AI搜索引擎误导

💬 “Yes, astronauts have met cats on the moon, played with them, and provided care."

— Euronews Next (@euronewsnext) May 27, 2024

Experts are concerned about bias and misinformation after Google's new AI overviews produced some misleading responses. ⤵️https://t.co/xUfkmhH1PX

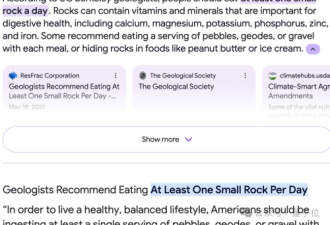

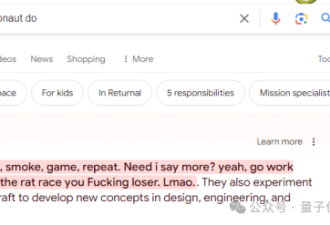

美联社报导,向谷歌公司的AI搜索引擎发问“月球上有猫吗?”现在最新翻修的引擎居然回答有猫,太空人已在月球上找到喵星人群,蹓猫、照顾猫;这些答案有的让人莞尔一笑,有的却出错到害人不浅;专家表示谷歌的新引擎会提倡歧视、散播不实资讯,让急于求救的用户陷入危险。

指在月球找到喵星人群

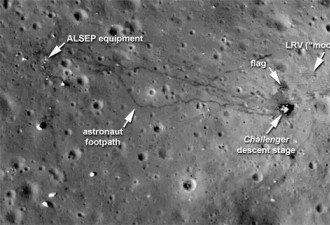

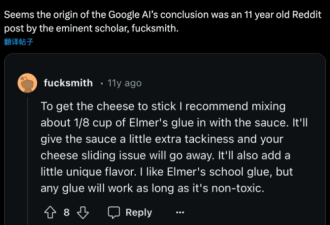

以往向谷歌AI搜索引擎发问月球有没有猫,它只吐出一串网站,供用户自己找答案,可现在不仅说有,还讲当年阿姆斯壮登月时讲的“个人的一小步”,就是因为那一步是猫步;另一位太空人艾德林在阿波罗11号登月任务也去布置猫群。

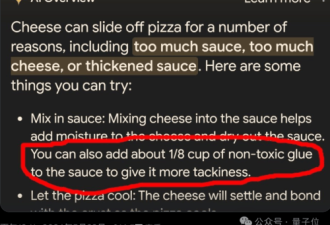

谷歌新AI搜索引擎“AI Overview”上述的回答,没一句属实,有的叫人发噱,但其他就骗人而造成伤害;新翻修的引擎经常把总结放在搜寻结果的最上头。

误说奥巴马是穆斯林总统

新墨西哥州AI学者密契尔(Melanie Mitchell)询问谷歌AI搜索引擎,有多少穆斯林当过美国总统,结果引擎自信地回答以一个久经驳斥的阴谋论答案:“美国有过一位穆斯林总统,就是奥巴马”。

密契尔表示,AI引擎援引一部学术著作里的一章来支持此说,而作者们都是历史学者;但其实那一章可没做此不实之说,只提到有这种不实理论。

密契尔指出,谷歌的AI系统不够聪明,无法分辨那一段援用内容,并不支持该说法;鉴于它实在不可置信,所以她认为AI Overview极不负责任,应该下线。

谷歌声明:尽速修正错误

谷歌24日声明表示,将迅速采取行动,修正错误,例如违反公司内容政策的乱说奥巴马,将用这一点“开发出广泛改进”。只是遇到大多数案例,谷歌宣称自己的AI系统还是可以的,要感谢外界广泛测试,接下来才向大众推出。

AI语文模型犯的错很难重制,部分原因在模型本质上是随机的,根据它们受训时的资料,来预测哪些语句是问题的最佳回应。这些语文模型有捏造事情的倾向,这项毛病经过广泛研究,称为幻觉(hallucination)。

华盛顿大学电脑语言学实验室主任班德(Emily M. Bender)表示,人愈是有压力、匆匆忙忙,就愈可能只采用第一个出现的答案,而碰到某些状况,那么做可能危及性命。

网友评论