iOS又要升级了 可能是苹果十年来最大升级

前两天,才有开发者发现,苹果竟然在向开源 WebKit 数据库提交新代码的时候,不小心把 iOS 15 和 macOS 12 的名字给写进去。

好家伙,最近还说苹果要严抓泄密者,结果它自己就先跑出来爆料了。

看来,iPhone 新一代系统 iOS 15,已经在路上。

而就在昨天晚上,苹果正式官宣今年 WWDC 大会的时间:6 月 7 日。

换算成北京时间,就是我们这边的6 月 8 日凌晨了。跟去年一样,今年还是线上录播的方式。

呐,每一年 WWDC 大会,苹果都会介绍 iOS、iPadOS、watchOS、tvOS、macOS 五个系统有什么更新,想必今年也不会有什么例外。

不知道机友们对于新的 iOS 15,有什么期待呢?

像之前,已经有传闻说,iOS 15 可能会换新设计,图标风格向现在 macOS Big Sur 的半拟物化、半扁平化靠近。

还有像息屏显示、App 分屏显示等等,也在网友的概念视频里出现过。

机哥觉得更详细的爆料,得等到发布会前一个月。

(网友做的概念图)

至于支持的机型,在今年年初,有一家外媒声称拿到苹果的内部资料,iOS 15 计划放弃对使用 A9 处理器或更早版本芯片的 iPhone 的支持。

也就是说,iPhone 6s/6s Plus 和 iPhone SE 初代,也许就要止步于 iOS 14 了。

而 iPhone 7 以及往后的机型,还是能继续升级 iOS 15 哒 ~

由于去年 iOS 14 才大更新过,机哥瞧目前这情况,今年又是小修小补的一年。

只是,今年 WWDC 最重磅的内容,也许根本不是 iOS 15。

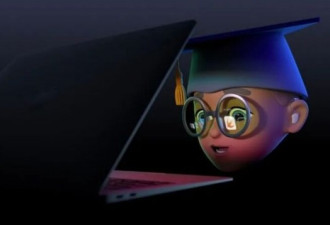

大家仔细瞧瞧,这次有很多张不同人物的海报,左边是一台 MacBook。

但是,右边无论是哪个人物,都会戴着一副眼镜。而眼镜里,悬空显示很多 App 图标。

这妥妥是在暗示,传闻已久的苹果下一代硬件:苹果 AR 眼镜啊。

如果机友们看的是视频版,就会发现哪怕小人没有操控电脑,但眼镜里的这些 App 图标,还是会动的。

再结合这次 WWDC 的主题是:Glow and behold。

直译过来中文,意思是:发光和看到。

机哥感觉这都不叫做暗示,而是明示了。

看来今年 WWDC 最重磅的产品,要不就是苹果的 AR 眼镜、要不就是苹果的 AR 系统。

讲真,苹果在做 AR 眼镜的传闻,已经好多好多年了。憋了这么久的大招,究竟会是什么样子的呢?

虽然说具体内容要等到 6 月 8 日当天才会宣布,但机哥灵机一动,我们可以先去翻翻苹果过去申请的相关专利,然后先睹为快啊!

(网友几年前做的概念图)

作为一款 AR 眼镜,怎么显示内容,固然是最重要的部分。

显示

AR 的意思是 " 增强现实 ",意思是把虚拟的内容跟现实结合起来,而并非像 VR(虚拟现实)那样创造一个虚拟的世界。

呐,苹果自己在专利里是这么介绍的:

诸如头戴式装置的电子设备可以包含产生显示图像的显示器。头戴式装置可以搭载允许用户查看真实世界对象和数字生成内容的光学系统。在操作期间,光学系统可用于将来自真实世界对象的真实世界图像与计算机生成的数字图像合并。

如果大家一时之间没听懂,那么机哥就简单举个例子吧。

机哥出门时,用 AR 眼镜进行导航。

其实它跟普通眼镜一样,现实该看到的东西,它都能看到。

唯一不同的是,它会把导航的内容,比如说往哪个方向走、还剩多少米,显示在屏幕上。

(概念图)

只是吼,苹果想更进一步的是,希望不同的内容,能显示在不同的位置上。

比如说," 该往哪个方向走 " 会显示在远处的地面上,而 " 还剩多少米 " 的提醒则近在眼前。

所以机哥看到,苹果上个月刚申请了一份叫做为 "Display systems with geometrical phase lenses"(具有几何相位透镜的显示系统)的专利。

这份专利主要描述的,就是通过一种特殊的透镜,让苹果 AR 眼镜能将显示的内容,放在距离眼睛不同焦平面的位置。

换言之,显示的内容能具有 " 深度 "。

但是哦,机友们可以想想看,我们平常戴着眼镜看东西,不仅我们眼睛不停转到不同的地方,而且眼前的景物也会不断变化。

辣么,既然变数这么大,苹果的 AR 眼镜又怎么能保证显示的内容,始终在我们盯着的地方呢?

于是苹果上个月,就在另一个叫做 " 具有时域交织的显示系统 " 的专利里,搞出一套注视追踪系统。

话说苹果想在眼镜装上三维传感器、LiDAR(激光雷达)或三维射频传感器等硬件,它们能协同工作,用于记录我们眼睛的聚焦位置。

(之前爆料中的苹果眼镜硬件)

有一说一,这可能是更精准版的 "Face ID"。

想想看,现在 iPhone 上的 Face ID,能检测到机哥有没有在注视手机。

而苹果的 AR 眼镜,就想更进一步,能检测出我们 " 盯 " 的位置是哪里。

并且有了这套系统后,苹果在专利里说:虚拟对象与真实对象之间,就没有延时产生了。

但这还没完!

机哥在找专利的时候,发现苹果除了堆硬件,也有想过怎么利用这些硬件,实现更多功能。

比如说,在去年一份 " 利用亮度变化来确定用户特征 " 的专利里,就提到检测瞳孔的变化,从而改变屏幕的亮度,进而评估我们的注意力。

如果用户在专心致志地投入工作时,内容的亮度增加,瞳孔的反应可能会比疲惫时更慢、幅度更小。

甚至检测到疲倦时,还会适时提醒我们休息一下。

这操作,还真的挺苹果 ~

辣么,屏幕能够显示了,我们又怎么跟里面的内容交互呢?

交互

苹果的想法是,把眼前摸到的所有物体,都变成可触摸。

专利来源:Method and device for detecting a touch between a first object and a second object(用于检测第一物体和第二物体之间触摸的方法和装置)

呐,在专利里,苹果想给 AR 眼镜,装入一个 " 红外热感应器 "。

我们触摸物体时,眼镜通过检测触摸物体时的热量变化,紧接着做出反应。

这里,苹果就举了一个具体的例子。

原本只是举起一块平平无奇的、刻着一个一个方格的、类似木板一样的方形物体。但戴上眼镜之后,看到的却是一个计算器。

通过机哥上面说到的技术,我们手指在计算器上点点按按,就像用一个真实的计算器一样。

但实际上,我们只不过在空气中点点按按罢了。这一切都是 " 红外热感应器 " 的功劳。

上面只是专利里的小例子,机哥觉得也许在未来,只要是我们能摸到的物体,就能变成交互的入口。

机哥看到有网友大开脑洞,是不是就可以把曾经 iOS 系统经典的滑动解锁拿回来,用来解锁苹果 AR 眼镜。

也许在旁边的人看过了,我们只是在桌子上一划,但实际上我们是在解锁眼镜。

机哥不得不说,这一届网友的脑洞很 ok 啊。

只是吼,如果想要更精确的操作,好像 " 红外热感应器 " 的精度不太够。

So,苹果还给 AR 眼镜申请了很多配件的专利。

触摸配件

去年,机哥已经给大家介绍过,苹果申请的 " 智能戒指 "、" 智能手套 " 专利。

像智能戒指,跟 Apple Watch 有点像,是用来检测我们手部的姿势。

而智能手套更进一步,里面有温度传感器用来模拟出冷热,也有压力传感器用来给我们提供一个压力的反馈。

也许当它们跟苹果的 AR 眼镜共同工作时,能同时给我们提供视觉、听觉、触觉。

想想看,我们不仅能看到一个虚拟物体长什么样、是什么颜色,还可以 " 摸到 " 它是暖还是热的、" 感受 " 到它有多重,甚至敲它、摸它、捏它是什么样的感觉 ……

听上去就很有未来感!

当然,这些都是苹果专利里的内容,最终能实现到哪种程度,还是要等到 6 月 8 日的 WWDC。

只是机哥今天也在感慨,虽然苹果这 AR 眼镜还没正式发布,但很多技术其实我们都见过了。

LIDAR 激光雷达,去年的 iPad Pro 和 iPhone 12,已经应用了一年多,如今甚至能计算出我们的手,是在虚拟物体的前面还是后面。

姿势传感器,在 Apple Watch 上已经更新了足足 6 代,现在对我们的运动姿势,能够非常精准的捕捉到。

而头部跟踪传感器,AirPods Pro 和 AirPods Max 去年发布的 " 空间音频 ",就是利用加速度传感器、陀螺仪来追踪我们的头部。

……

我们一直以为苹果 AR 眼镜离我们很远,也许苹果在不知不觉中,已经完成了很多测试。

这样的苹果,想想还挺可怕的。

所以说,可能 iOS 15 只是这次 WWDC 的开胃菜,而 AR 眼镜才是苹果真正的大招。

网友评论