英国要准备和机器人讲道德…这逻辑也是看不懂

机器的智能化正在逐步深入到生活领域:客机自动降落,列车无人驾驶,(真)自动驾驶的汽车上路也是指日可待(此处没有黑特斯拉)。

英国研究人员开始有些担心,机器越来越聪明智能,说不好哪天拥有自主意识的机器人就掌控着人类的生死——正如电影《2001太空漫游》里智能计算机“哈尔”面临的选择一样。

当机器人不再尊重人类时,我们就摊上大事了。

毕竟当未来机器人能够做任何想做的事情时,人类就要开始头痛如何避免机器人犯罪。这就是英国的研究人员为什么要强调,智能机器人必须尊重人权(包括隐私、身份认同和自主权),不符合道德的机器人,就不应当被制造出来。

尊重人权的道德标准是什么?

英国标准协会(British Standards Institute,简称 BSI)在牛津大学 Social Robotics and AI 大会上发布了一套代号为 BS 8611的机器人伦理指南,全称为《机器人和机器系统的伦理设计和应用指南》。西英格兰大学教授 Alan Winfield 称该指南为“将道德价值观嵌入机器人和 AI 的第一步”。

这份新指南在关于处理多种机器人应用问题上,将帮助设计者、用户、自动系统,建立一种新的工作视角。

“据我所知这是第一个关于机器人设计上的伦理标准”,Winfield 在会议结束后说,这比 Asimov 的法律更复杂一些,基本上规定了如何评估机器人的道德风险。

Asimov 的法律指的是科幻小说家 Isaac Asimov 在曾在短篇小说内提出规范机器人行为的三定律,分别是:

1)机器人不得伤害人类,或袖手旁观让一个人受到伤害

2)机器人必须服从人类的命令,除非与第一定律相矛盾

3)只要不与第一、第二定律冲突,机器人就必须保护自己

但这部由科学家、研究员、伦理学家、哲学家和机器人用户提供意见而成的 BS 8611指南显然比这三定律更复杂成熟。

指南声明,制造机器人设计不得以伤害人类为专门或主要目的,并且负责任的主体是人类,任何机器人的行为都应当有人类负责。同时,机器人的道德危害不一定是人身伤害,造成恐惧、紧张这样的心理危害也应当纳入考量。

在用以参考的道德评估标准下,BS 8611建议设计者应当更关注机器人设计的透明性,但科学家们表示这点臣妾做不到。

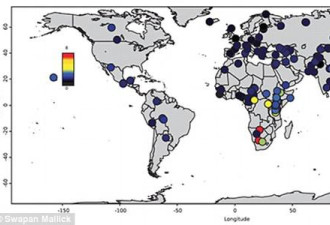

Winfield 表示,机器人、AI 的深度学习系统都是基于整个互联网数据上反复练习,而这种学习和做出决策的过程,有时候设计者都无法理解。潜在的性别、种族歧视也是机器人潜在的道德风险。人工智能的深度学习系统基于互联网数据,而这些数据本身就存在着偏见。

整个大数据更有利于中年白种人。

这显然是一场灾难,当机器人消化吸收了所有人类的偏见,对技术应用的影响显而易见。目前已出现的典型情况就是,语音识别在理解女性声音时表现差一点;面部识别时,黑人则比白人难以识别。

尽管 BS 8611 指南主要针对的人群是机器人设计者和制造商,主要目的是保证人类制造的智能机器人,能够融入社会现有的道德规范,其中重要的一点就是“不许欺骗”。

这就涉及到了一些争议,比如允许人类和机器人产生感情吗?特别是机器人的设计目的是为了与小孩、老人互动。

谢菲尔德大学名誉教授 Noel Sharkey 认为,这就是机器人在无意的情况下欺骗人类的例子,机器人是没有感情的,但人类可不这么想。在最近的一项研究里,把小机器人放到一所幼儿园里,非常受孩子喜爱,并且孩子认为这些机器人比宠物具有更高的感知能力。

除了不许伤害、不许欺骗,对机器人的过度依赖也是一个潜在的社会问题。

英国标准协会的 Dan Palmer 认为,使用机器人和自动化技术使得流程更加高效、灵活,这也是制造业快速增长的重要组成部分,但当你与机器人共事一段时间后,它一直在给予你正确答案,但在你养成了依赖的习惯后,它会给出非常愚蠢的建议。

生活中“过度依赖机器人”也是潜在的威胁。路透社有文章指出,有科学家表示性爱机器人会使人成瘾,因为机器人不会拒绝。

指南中也提到了这种“过度依赖机器人”现象,但在这类问题上并没有给机器人设计者确切的准则,有待补充。

当然,人也不是每时每刻都能做到行为道德。当大脑误入歧途时,我们可能需要进行道德治理。在教导智能机器人道德行为时,尤其制造机器人处理残疾、智障人群问题时,我们也可能在完善对人类表现的道德建议。

讲真,和机器人讲道德可能使我们更加人性化。

网友评论